Як пережити Google-апдейти та не втратити трафік на сайті

Здавалося б, ще вчора у вас було стабільне зростання трафіку, а сьогодні – різке падіння в аналітиці. Причина? Новий апдейт від Google! Оновлення алгоритмів Google – один із тих чинників, які змінюють правила гри буквально за ніч для всіх, незалежно від ніші чи типу бізнесу. І якщо ви не готові – сайт може втратити видимість і позиції в пошуковій системі, а з ними й потенційний прибуток.

Проте апдейти – це не завжди катастрофа. Часто вони дають шанс переосмислити підхід до SEO, переглянути якість контенту, технічний стан сайту та його структуру. Отож, не поспішайте з пошуком способу, як захиститись від апдейтів Google. Ті, хто вчасно адаптуються, – виграють. Головне розуміти, як діяти до, під час і після таких оновлень.

У цій статті ми розберемо, як працюють Google-апдейти, чому вони так сильно впливають на результати видачі, та поширені причини падіння трафіку після оновлення Google. Ви дізнаєтесь, що робити після Google-апдейту, щоб убезпечити свій сайт від різких коливань після оновлень. Додатково поділимося власним кейсом з досвіду Livepage – як ми допомогли сайту повернутися в топ видачі після чергового апдейту.

Що таке апдейти Google та чому вони важливі

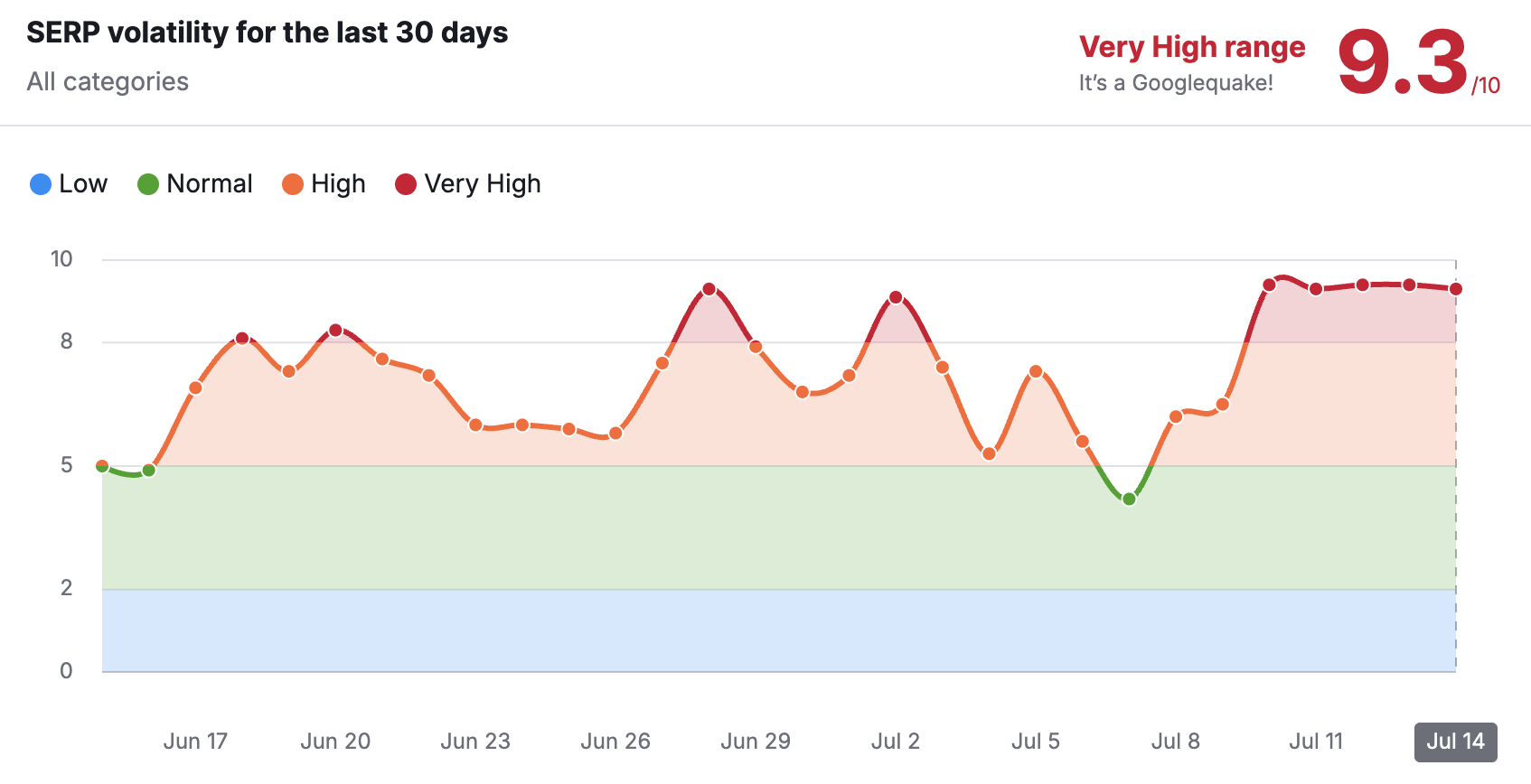

Google постійно вдосконалює власні алгоритми ранжування, щоб показувати користувачам максимально релевантні, якісні та безпечні результати. Для повного розуміння, апдейти якраз і є оновленням цих алгоритмів. Вони можуть бути незначними та проходити майже непомітно для більшості сайтів. Але нерідко відбуваються масштабні оновлення Google з дійсно відчутними змінами у видачі, які позначаються на мільйонах сайтів не тільки в конкретній ніші, а й в межах всієї пошукової системи.

Ціль кожного апдейту, на перший погляд, досить проста – зробити видачу кращою. Проте так зване «краще» за версією Google не завжди означає таке ж «краще» для SEO-фахівців чи власників бізнесу. Те, що працювало вчора, може втратити свою ефективність після оновлення. Саме тому важливо розуміти логіку таких змін і вчасно підлаштовувати власну SEO-стратегію.

Як ми вже згадували, апдейти можуть зачепити як певні типи сайтів (наприклад, медичні, новинні, eCommerce, HoReCa), так і окремі аспекти, що стосуються всіх ніш: якість контенту (без втручання ШІ), природність посилального профілю, зручне юзабіліті, поведінкові сигнали, експертність авторів блогу тощо. Тому вплив апдейтів Google на сайт і всі дотичні до нього чинники – це не питання «чи», а питання «коли» й «наскільки сильно».

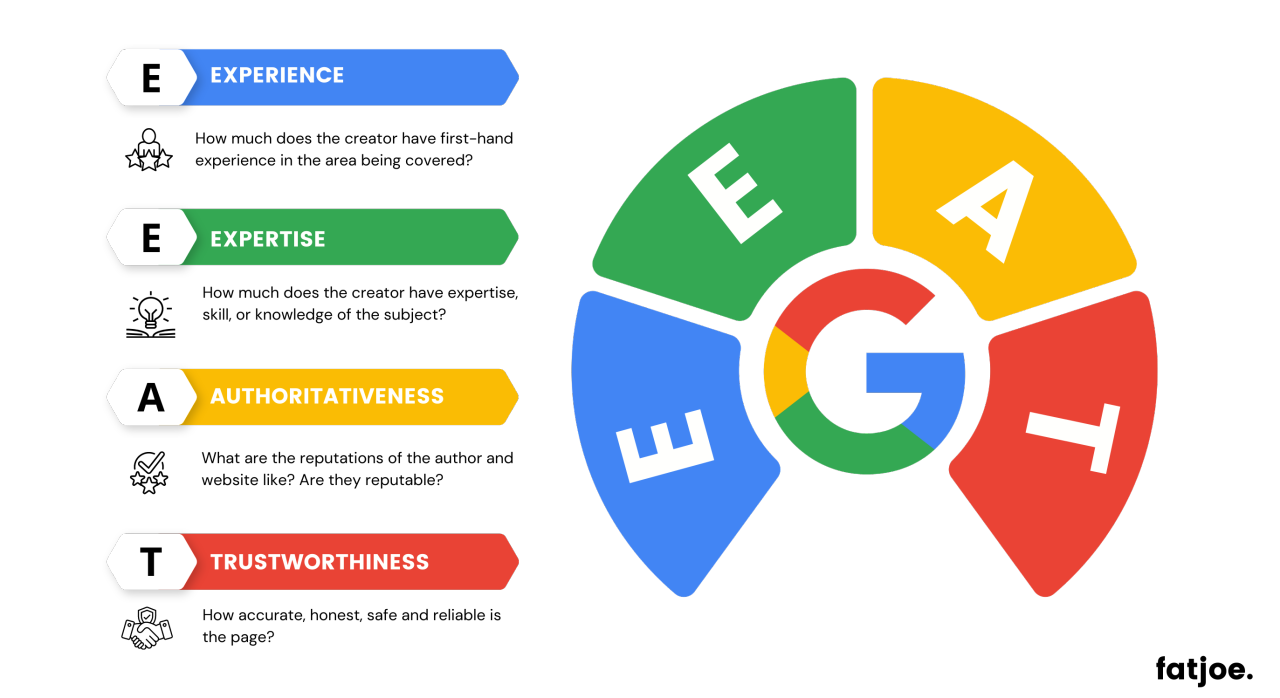

Отже, коли змінюються вимоги до якості контенту чи E-E-A-T-факторів, SEO-стратегія кожного окремого бізнесу має адаптуватися індивідуально. Для когось зазнає змін підхід до написання текстів, розставлення акцентів у структурі, для інших – підбір ключових запитів і навіть манера спілкування з аудиторією. Апдейт може змусити докорінно переглянути контентну стратегію сайту, нехай раніше вона і приносила позитивні результати.

Оновлення Google мають не менший вплив і на лінкбілдинг (про такі види Google-апдейтів ми поговоримо пізніше): з кожним з них Google стає дедалі жорсткішим до неприродного посилального профілю сайтів. Після деяких оновлень сайти з масовими нерелевантними чи спамними посиланнями можуть просто втратити довіру Google, і тоді стратегія «чим більше лінків – тим краще» вже не працюватиме.

Крім того, з кожним апдейтом зростає і важливість технічного SEO та юзабіліті. Алгоритми Google теж мають здатність «навчатися», а тому дедалі краще розуміють, як користувач взаємодіє із сайтом. Повільний, незручний або банально застарілий за функціоналом сайт – це явний сигнал для Google про те, що користувачеві тут некомфортно.

Розуміння того, як працюють Google-апдейти, дає можливість не просто реагувати на зміни в «політиці ранжування», а діяти на випередження – будувати довгострокову SEO-стратегію, яка не боятиметься наступного оновлення алгоритмів.

Які бувають Google-апдейти і як вони можуть вплинути на сайт

Google випускає десятки оновлень щороку. Більшість із них малопомітні, проте деякі – досить масштабні – здатні змінити пріоритети в пошуковій видачі (наприклад, March 2024 Core Update). Такі оновлення називають Core Updates – фундаментальні зміни в оцінці якості контенту, авторитетності сайту та його відповідності інтенту користувача. Їхній вплив поширюється майже на всі ніші, тому є найбільш відчутними.

Core Update – фундаментальні оновлення (3–4 рази на рік)

Google Core Update – це наймасштабніші апдейти, що зачіпають загальну логіку оцінки: контенту, E-E-A-T-факторів (досвід, експертність, авторитетність і надійність) та відповідності запитам користувача. Вони не націлені на конкретну нішу, а охоплюють видачу загалом – від блогів до онлайн-магазинів. Після Core Update найчастіше можуть просісти сайти, які роками були в топі, й навпаки – отримати зростання ті, хто давно працює над якістю свого контенту.

На які показники впливає найбільше:

- Середня позиція за ключовими запитами.

- Кількість сторінок у топ 10.

- Трафік і переходи за інформаційними запитами.

- CTR сторінок у пошуковій системі.

Саме Core Updates найчастіше спричиняють всім відому хвилю просадок. До них варто готуватися заздалегідь, розбудувавши довгострокову SEO-стратегію. В основному такі апдейти відбуваються 3–4 рази на рік з інтервалами в 3–4 тижні.

Helpful Content Update – боротьба зі «штучним» контентом (1–2 рази на рік)

Метою цього оновлення є перевірка, чи дійсно ваш контент написаний для людей, а не для пошукових ботів. Якщо на сайті багато автоматично згенерованих текстів (переважно продуктів ШІ-копірайтингу), SEO-контенту без реальної користі для читача, дублів або банальних переписувань чужих думок, знайте – зниження трафіку вас не омине.

На які показники впливає найбільше:

- Трафік і переходи за інформаційними запитами (блог).

- Позиції новостворених сторінок сайту, зокрема статей.

- Присутність сторінок в індексі пошукової системи Google.

З 2022 року Google почав дедалі активніше впроваджувати цей алгоритм, і він продовжує розвиватися через зростання популярності LLM-моделей штучного інтелекту.

Spam Update – нагляд за «сірою зоною» SEO (кілька разів на рік)

Google регулярно оновлює власні антиспам-фільтри, аби боротися з маніпуляціями у видачі: масова купівля посилань, прихований текст, doorway-сторінки, клоакінг, PBN-мережі тощо. Частота таких апдейтів найвища серед усіх типів. Оскільки маніпулятивні тактики змінюються частіше, ніж світові тенденції, Google просто необхідно підтримувати відповідну «чистоту» пошукової видачі.

На які показники впливає найбільше:

- Загальна видимість домену в пошуковій системі.

- Відпадання лінків із посилального профілю.

- Зниження трасту (часто неочевидне, але відчутне за позиціями).

- Повна або часткова деіндексація сторінок.

Вплив Spam Update зазвичай не має масового характеру та є більш точковим – зачіпає конкретні сайти, які дійсно порушують правила просування.

Product Reviews Update – спеціалізоване оновлення для оглядів (1–2 рази на рік)

Здебільшого це оновлення позначається на сайтах, які публікують огляди товарів або послуг. Оскільки для Google досвід користувача та повне задоволення його потреб є найціннішими, він надає перевагу справжнім тестам, порівнянням і глибокому аналізу – замість банальних «збірок з інтернету». Якщо ваш контент має низьку додану цінність – будьте готові втратити позиції.

На які показники впливає найбільше:

- Видимість за комерційними та трансакційними запитами.

- Позиції сторінок, що містять огляди та заголовки на кшталт «Найкращі/Топ/Огляд».

- Наявність розширеного сніпету (особливо «каруселі» з рейтингами).

Актуально для affiliate-сайтів, інтернет-магазинів і блогів з оглядами товарів, техніки та послуг тощо. Однак через те, що оцінка доданої цінності кожного продукту дещо субʼєктивна річ, цей апдейт не є надто популярним і відбувається близько 1–2 разів на рік.

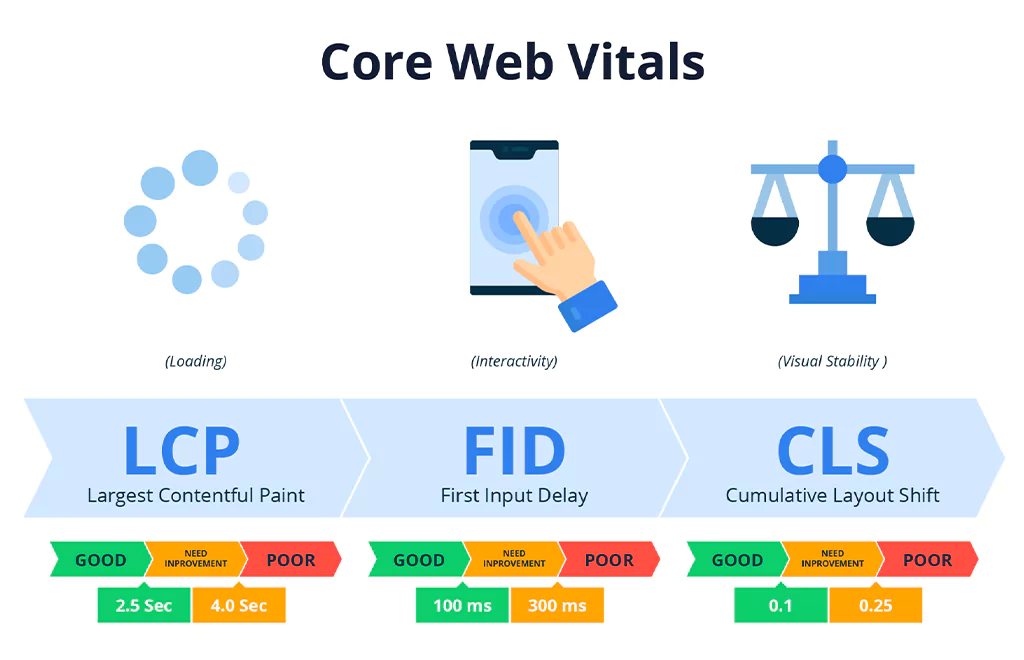

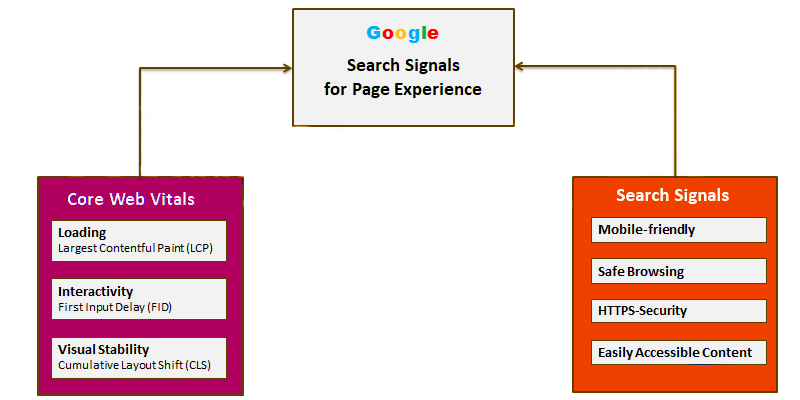

Page Experience та Core Web Vitals – сигнали зручності (оновлюються поступово)

Це оновлення не належить до раніше згаданих класичних апдейтів. Його метою швидше є постійна зміна акцентів у ранжуванні на користь сайтів із хорошим юзабіліті. Оцінюються різноманітні метрики, що безпосередньо впливають на зручність відвідувача в користуванні сайтом: швидкість завантаження, інтерактивність, стабільність верстки для ПК і мобільних пристроїв тощо.

На які показники впливає найбільше:

- Загальні позиції за пошуковими запитами з ПК і мобільних пристроїв.

- Показники Core Web Vitals у Search Console.

- Присутність сторінок в індексі пошукової системи Google.

Їхній вплив не завжди миттєвий, скоріше він має накопичувальну дію: поганий Page Experience = постійно відкриті двері для просадки позицій вашого сайту.

Отже, кожен тип апдейту по-своєму впливає на ранжування вашого сайту в пошуковій системі. За умови системної роботи над якістю контенту, природністю та якістю зовнішніх посилань, технічною оптимізацією, найімовірніше, більшість оновлень не становитимуть загрози. Проте якщо є «слабкі місця», навіть найменш помітні, Google обов’язково їх знайде. А от коли це станеться, залежить тільки від типу апдейту, під який ви потрапите.

Чому сайти просідають після оновлень Google: головні причини

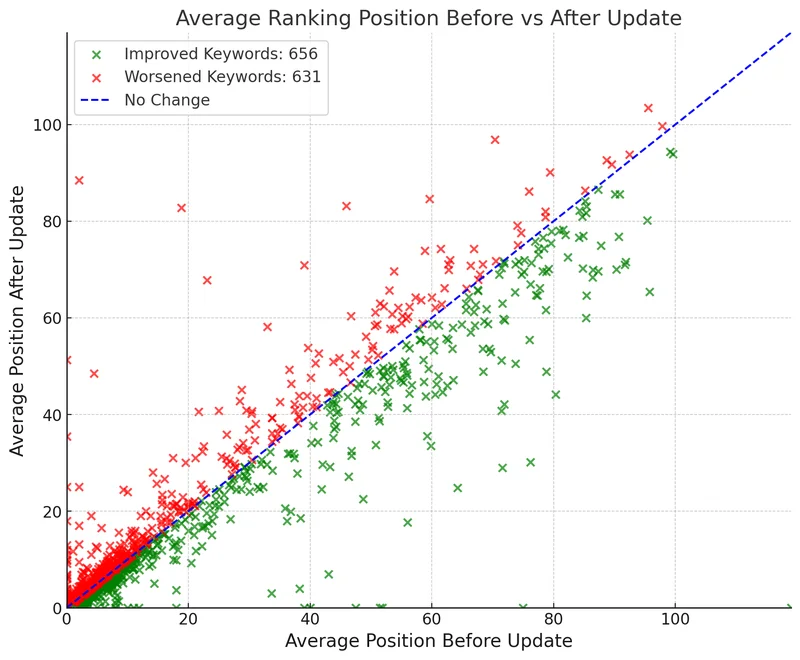

Після релізу великого апдейту можна побачити один з трьох варіантів розвитку подій: зростання, стабільність або ж просадку. І якщо зростання – це приємний бонус, то просадка завжди спричиняє паніку. Важливо розуміти, що Google не карає «просто так» – він змінює пріоритети. Тож в разі втрати трафіку після оновлення ви маєте усвідомлювати, що ваш сайт більше не відповідає новим вимогам пошукової системи. Як дізнатись, чому просів сайт після апдейту Google? Зупинімось на кількох найпоширеніших причинах просадок після оновлення алгоритмів Google.

Низька якість контенту

Сайти з поверхневими статтями, переписаними з інших джерел, без глибини аналітики або авторського підходу першими потрапляють під фільтри Helpful Content або Core Updates, особливо якщо таких сторінок багато. Чимало сайтів мають десятки «порожніх» за сенсом статей, цілеспрямовано створених для охоплення семантики, а не для задоволення потреб користувача. Саме вони часто тягнуть загальний рейтинг вашого ресурсу вниз.

Відсутні або слабкі E-E-A-T-фактори

Google все більше надає перевагу сайтам, які чітко демонструють свою експертність і авторитетність у певній тематиці. Якщо на вашому сайті немає жодної згадки про авторів, їхніх профілів, експертної подачі або ж ваша тематика «чутлива» (медицина, фінанси), відсутність E-E-A-T може критично вдарити по довірі до ресурсу.

Проблемний лінкбілдинг

Спамні та неприродні посилання, що купуються просто «пачками», застарілі PBN і згадки на нетематичних ресурсах – усе це сигналізує Google, що ви намагаєтесь обманути та обіграти його алгоритми. Якщо в момент апдейту на вас «висять» проблемні донори або ж раптово з’явилася хвиля неякісних беклінків (можливо, через конкуренцію чи «чорний» маркетинг), існує високий ризик потрапити під фільтр Spam Update.

Технічні помилки та повільний сайт

Навіть хороший контент не «вистрілить», якщо сторінки повільно завантажуються, користувач плутається у банальній навігації по сайту або ваш ресурс має погано адаптовану мобільну версію. З кожним новим апдейтом технічна складова стає дедалі вагомішою: Page Experience, Core Web Vitals, адаптивність – усе це критично важливо для підтримки стабільності позицій вашого сайту.

Застаріла структура або «канібалізація» запитів

Іноді просадка відбувається зовсім не через «штраф», а через те, що Google інакше інтерпретує справжній інтент користувача. Якщо ваш контент перетинається та канібалізує запити з іншими сторінками або ж структурується вкрай нелогічно, Google обирає умовно «кращу» сторінку, а решту знижує в позиціях (детальніше розібрали в цій статті).

Шаблонний або ШІ-створений контент

Останні апдейти показали: просто опублікувати згенерований чи шаблонний текст недостатньо. Коли контент не має практичної цінності, не дає унікального досвіду користувачу або повторює все, що вже присутнє у видачі, він втрачає позиції. Алгоритми навчаються розпізнавати не лише машинний стиль, а й корисність такого контенту для споживачів.

Як підготуватись до Google апдейтів і зменшити ризики

Жоден сайт не застрахований від впливу апдейтів. Проте це не означає, що варто пасивно чекати й перейматися, як пережити апдейт Google. Подбайте про вживання необхідних заходів для мінімізації ризиків просадки, а ще краще – спрямуйте свої зусилля на отримання зростання після наступного оновлення алгоритмів.

Проводьте регулярний контент-аудит

Навіть якщо сайт має гарний вигляд, час від часу варто переглядати контент. Зверніть увагу на матеріали, які є застарілими, дублюються, недостатньо цінні або мають багато помилок у зіставленні із фактичними даними. Статті, що зовсім не приносять трафік і не відповідають новим стандартам, краще оновити або ж зовсім видалити.

Порада: приблизно раз на квартал складайте список сторінок із низькими показниками: трафік, час перебування користувача на сторінці, bounce rate, і переглядайте їх на відповідність вимогам Google та останнім тенденціям.

Розвивайте E-E-A-T (особливо в нішах YMYL)

Додайте авторів і створіть для кожного окрему сторінку-профіль, зробіть цитування в статтях, що відображали б вашу експертизу. Наприклад, якщо блог веде лікар, покажіть диплом, надайте посилання на його досягнення, відвідувані конференції тощо. Даєте фінансові поради? Поясніть, чому саме вам варто довіряти. Google шукає реальні докази, що ваш контент написаний не випадковими людьми, а тими, хто має експертизу в певній сфері.

Порада: створіть сторінку «Про експерта» та лінкуйте на неї з усіх публікацій блогу відповідного автора.

Оновлюйте структуру контенту та внутрішню перелінковку

Інформаційна архітектура сайту має бути логічною: групуйте статті за категоріями, додавайте перелінковку між схожими темами, створюйте своєрідні кластери-хаби (так звана pillar-стратегія). Це допомагає алгоритмам краще розуміти, чим пов’язані між собою такі сторінки.

Порада: використовуйте аналіз канібалізації запитів, щоб уникати конкуренції між власними сторінками.

Регулярно перевіряйте технічний стан сайту та Core Web Vitals

Технічна оптимізація – це вже не просто плюс, а так званий «гігієнічний мінімум». Швидкість завантаження, адаптивність, коректна робота мобільної версії – усе це прямо впливає на ранжування вашого сайту.

Порада: використовуйте інструменти на кшталт PageSpeed Insights, Search Console та WebPageTest, щоб «тримати руку на пульсі» та вчасно реагувати на зміну ваших Core Web Vitals.

Контролюйте якість посилального профілю

Намагайтесь раз в 1–2 місяці перевіряти беклінки в пошуках спаму або нетематичних донорів. Навіть якщо ви не купували такі посилання, замість вас це могли зробити конкуренти або ж просто привʼязатися випадкові спам-лінки. У разі виявлення проблеми використовуйте Disavow Tool від Google для швидкого відхилення таких посилань.

Порада: не женіться за кількістю посилань – краще мати 5 тематичних беклінків з хороших сайтів, аніж 50 сміттєвих.

Що робити, якщо трафік вже впав після Google-апдейту

Після оновлення алгоритмів падіння трафіку не завжди є результатом ваших помилок. Іноді це просто неминуче. Головне – не панікувати, а діяти послідовно. Відкат трафіку – це не кінець, а лише сигнал про те, що Google змінив свої вимоги. Ваше завдання з’ясувати, що ж змінилося:

- Переконайтесь, що причина справді в апдейті

Перш ніж щось змінювати, проаналізуйте дати падіння трафіку та порівняйте їх з часом офіційних оголошень Google про оновлення. Важливо зрозуміти: ваша ситуація дійсно пов’язана з алгоритмом чи причини полягають дещо в іншому. Це, зокрема, можуть бути технічні налаштування сайту, тенденції сезонності або ж зміна попиту на продукт/послугу (наприклад, конкурент дедалі активніше став просувати власну продукцію).

Порада: використовуйте не лише в Search Console, а й сервіси типу Semrush/Ahrefs/SerpStat – порівнюйте тренди з реальною ситуацією на ринку.

- Зробіть фокус на контент-сторінках, що просіли

Чітко визначте, які саме сторінки втратили позиції. Спробуйте визначити закономірності: можливо, вони всі написані в одному стилі (шаблонні), мають однакову структуру (канібалізація), містять ШІ-текст чи дублюють інформацію з інших джерел. Якщо причина очевидна, краще видалити або оновити такі матеріали.

Порада: відстежуйте не лише зниження рейтингу, але й падіння видимості за окремими кластерами ключових запитів, наприклад, за допомогою SerpStat чи SE Ranking.

- Проведіть аудит E-E-A-T-факторів

Оцініть, наскільки ваш сайт виглядає авторитетним: чи є на ньому сторінки авторів, контактна інформація, посилання на першоджерела, статистичні дані та решта інформації, що підтверджують ваш експертний досвід. Особливо критичне значення цих факторів для медичних, фінансових та юридичних сайтів, які безпосередньо впливають на добробут користувача.

Порада: якщо працюєте в одній з таких чутливих ніш, спробуйте додати більше зовнішніх згадок про вашу експертність, як-от: інтерв’ю, виступи, статті, конференції, згадки в медіа.

- Перегляньте технічну оптимізацію та юзабіліті сайту

Неочевидна просадка могла статися через банальне погіршення Page Experience: наприклад, в мобільній версії «з’їхала» структура або ж новий шаблон сторінки ускладнив навігацію користувача. Аналізуйте швидкість, адаптивність, стабільність візуальних елементів сайту (метрики, що відносяться до Core Web Vitals).

Порада: перегляньте власний сайт як звичайний користувач – наскільки легко знайти відповідь на ваше питання, чи видно CTA, чи швидко все працює?

- Не поспішайте переробляти «все й одразу»

Одна з найпоширеніших помилок – миттєво змінити весь сайт або видалити десятки сторінок. Апдейти часто тривають від кількох тижнів до місяців. Алгоритм може спробувати перевірити, як ваш сайт функціонує в динаміці. Якщо почнете різко змінювати все й одразу, ризикуєте тільки погіршити становище.

Порада: намагайтеся виявити та працювати тільки з проблемними ділянками, «точково» – проводьте А/B тестування, відстежуйте вплив таких змін і тільки потім приймайте остаточні рішення.

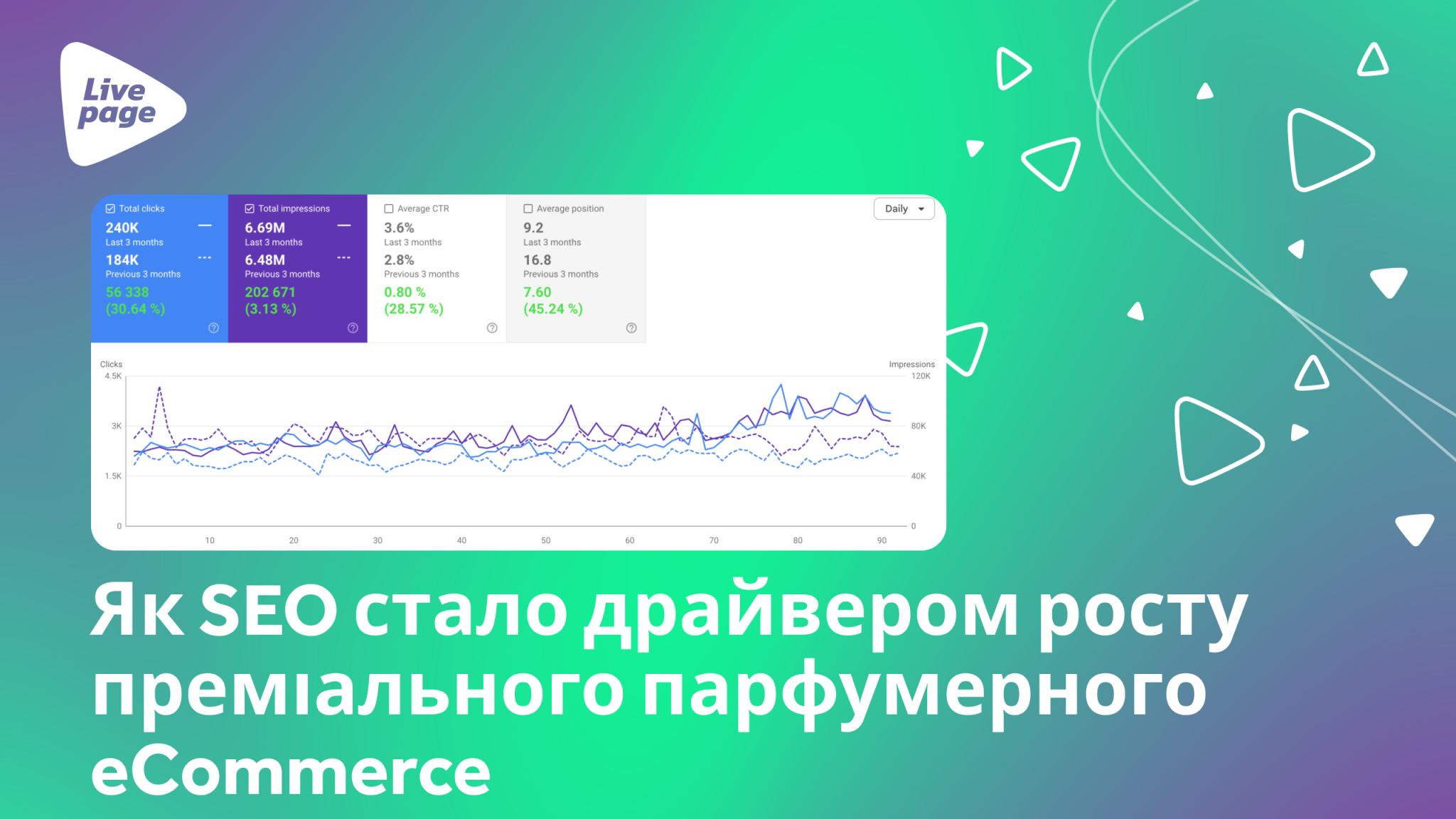

Як Livepage вивели сайт з просадки після Google апдейту

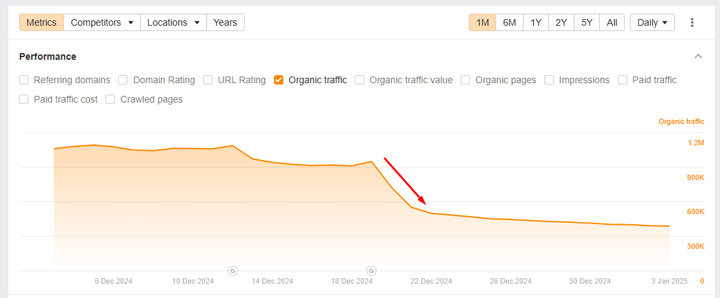

Розгляньмо на практиці, як правильно реагувати на втрату трафіку через оновлення Google. Один із кейсів нашої команди – SEO-просування SaaS-платформи Stripo.email, яка спеціалізується на створенні шаблонів листів для email-розсилок.

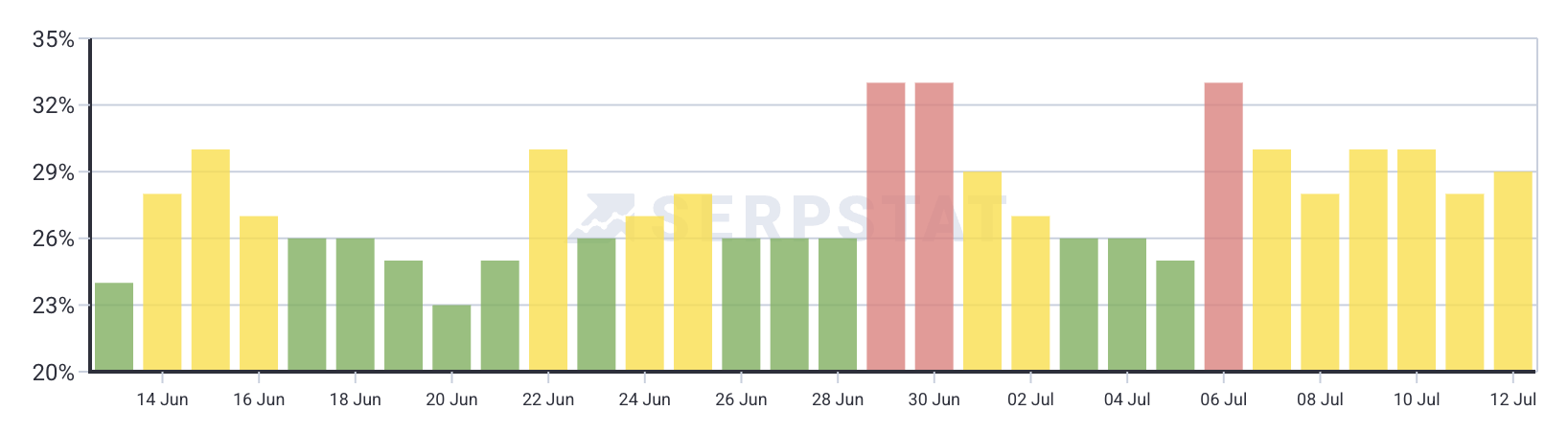

З Google-апдейтами ми постійно стикалися під час роботи над цим проєктом. Сайт працює у висококонкурентній ніші, з великою кількістю контенту переважно англійською мовою, і практично кожне велике оновлення алгоритму Google впливало на загальну динаміку трафіку. Особливо критичною була ситуація після одного з Core Updates, коли ми помітили найбільшу просадку за весь період співпраці.

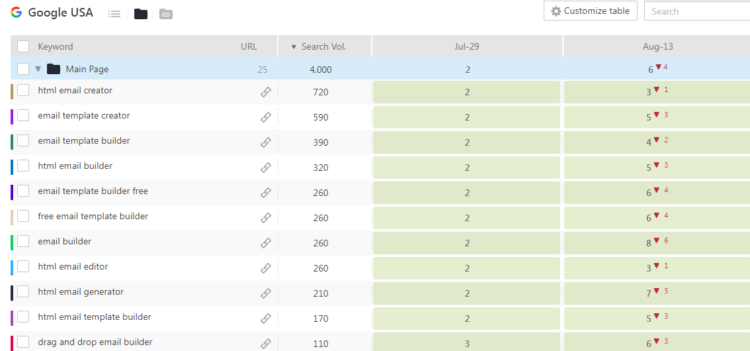

Для аналізу впливу на SEO після апдейту Google й встановлення причин втрати трафіку ми провели глибокий контентний і технічний аудит. Було виявлено понад 200 шаблонних сторінок, які не мали ніякої унікальної цінності: повторювали один і той самий формат, зовсім не були оптимізовані під пошукові запити й на вигляд скидалися на «технічні дублікати». Це створювало той самий ефект «відсутності доданої цінності», який Core Update міг трактувати як зниження якості ранжування всього сайту.

Крім цього, на сайті ми помітили й інші суттєві недоліки, наприклад: некоректно налаштована hreflang-розмітка для мовних версій, технічні помилки в блозі, баги в індексації окремих типів сторінок тощо.

Загалом перед нами постала комплексна проблема – як оптимізувати сайт після оновлень Google. Вона потребувала системного підходу з боку команди. Тому в процесі співпраці з клієнтом ми вжили таких заходів:

- Визначили всі слабкі сторінки з нульовим або мінімальним трафіком: частину видалили, деякі закрили від індексації, решту дооптимізували.

- Провели оптимізацію внутрішньої структури: впорядкували навігацію між сторінками, оновили пріоритети категорій, впровадили ручне перелінкування та шаблони метатегів.

- Виправили технічні проблеми: налаштували коректний hreflang та канонікали для сторінок, прибрали дублі контенту.

- Підготували оновлений контент-план. Зробили акцент виключно на унікальності й користі для читача, а не на кількості для ширшого охоплення семантики.

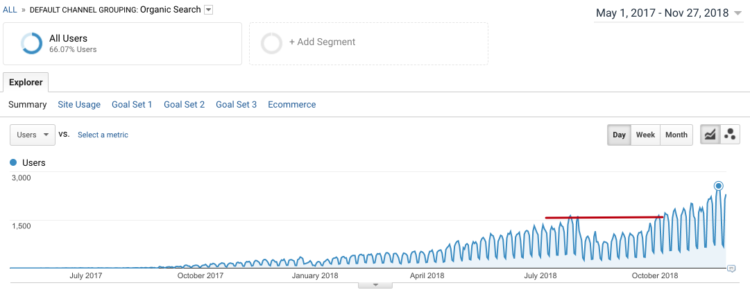

І результат не змусив нас довго чекати – вже після наступного Core Update сайт стрімко повернувся в органічну видачу й показав приріст не лише в трафіку, а й у відсотку конверсійності та продажах.

Надалі ми ще неодноразово оновлювали сайт під нові алгоритмічні вимоги. Завдяки цьому системному підходу наступні апдейти вже не спричиняли значних просадок для вебресурсу нашого клієнта.

Висновок

Потрібно памʼятати, що Google постійно змінює правила гри. Алгоритми стають дедалі складнішими, і якщо раніше можна було вибитися в топ лише завдяки лінкбілдингу чи великій кількості контенту, то зараз цього недостатньо. Кожен апдейт – це своєрідна перевірка сайту на витривалість і цілісність. Google зважає на все: контент, юзабіліті, швидкодію, експертність.

SEO сьогодні – це не про окремі дії. Це про системну роботу з усіма зонами ризику: від текстів до серверних налаштувань, від контент-плану до зворотних посилань. І найголовніше – це про розуміння логіки Google, а не лише правил, які він диктує.

Хочете бути впевненими, що наступний апдейт не зламає ваші позиції?

Команда Livepage вже понад 12 років працює з SEO у висококонкурентних нішах, неодноразово виводила проєкти з-під фільтрів Google, просувала стартапи з нуля та допомагала компаніям зростати після значних просадок. Ми знаємо, як працює Google і як будувати довгострокову стратегію, яка не боїться оновлень. Залишайте заявку, і ми допоможемо вивести ваш бізнес у топ.